El movimiento de los

cuerpos celestes ha inquietado a la humanidad desde siempre. Fué la

primera ciencia emprírica en desarrollarse, pero también estuvo

sujeta a interpretaciones de carácter religioso.

|

| Babilonios, egipcios, árabes, renacentistas... |

Desde el inicio de

la civilización el movimiento de los astros ha sido de gran interés económico, pues determinaba los ciclos

de dia y noche, las estaciones y, con ello, el mejor momento para

cultivar los campos o cosecharlos. Por eso no es de extrañar que fuese la primera ciencia empírica en ser

desarrollada y precursora del

estudio científico. Con toma de datos, análisis de los mismos y

búsqueda de explicaciones. Como ya hemos dicho, también ha tenido

importancia en el terreno religioso, pues no se sabían explicar

fenómenos naturales y esto suscitaba la existencia de seres

superiores que los provocaban y que, también, movían

los objetos observados en los cielos (la luna, el sol y algunos

planetas y estrellas). De hecho tuvo un gran calado social, pues en

2016 aunque Neil A. Amstrong pisó la luna en 1969, se han enviado miles de

satélites artificiales al espacio así como sondas y

más naves tripuladas. Incluso se ha construido una estación

espacial internacional! Aún podemos leer el horóscopo en cualquier

revista o periódico. Y el horśocopo se basa en la posición de los

astros. O sea, que aún habiendo viajado por el espacio, la

interpretación religiosa sigue viva.

Pero volvamos al

tema principal. Ya hemos dicho que fué la primera ciencia en

desarrollarse como tal. Se tienen datos de que en la antigua Babilonia (5000 años a.C) ya era de interés general. Así como

calendarios realizados por diferentes culturas basándose en el

movimiento de los astros.

No fué hasta el

siglo V a.C. cuando se planteó el problema de qué posicion ocupaba

nuestro planeta en realción al resto de astros observados. El dilema

surgió en la Grecia de aquella época. De hecho, los griegos

llamaron “planetas” a todos los astros en los que percibían

movimiento, pues planeta en

griego significa errante

(que erra, que se mueve, que no está quieto, vamos). Para

encontrar solución a este dilema de gran importancia, se plantearon

dos posibles explicaciones:

1.-

Explicación de Eudoxio: La Tierra se encuentra en el centro del

universo. El resto de los astros se necuentran situados sobre esferas

concentricas al centro de la Tierra y que giran en diferentes

sentidos respecto a la posición de la tierra (modelo

geostático).

2.-

Explicación de Aristarco: El Sol se encuentra en el centro del

universo y el resto de

astros. Al igual que en el modelo de Eudoxio, giran sobre esferas

concéntricas al centro del Sol (modelo heliostático).

No

es de extrañar que ambos modelos utilizaran esferas para explicar el

fenómeno observado, pues en la antigua grecia, la esfera era

considerada como la forma geométrica perfecta y. Si los dioses

movían los astros, debían vivir situados sobre esferas.

El

modelo de Aristarco no prosperó, pues no explicaba la sensación que

tenían (y tenemos) de inmovilidad. Tampoco explicaba la no

apreciación de movimiento de algunas estrellas y, más aún, creían

que si la Tierra era la que se movía, debía existir un viento

contínuo e unidireccional debido al movimiento.

Aristóteles

contribyó a mejorar el modelo de Eudoxio. Agregó más esferas y

subesferas para explicar el extraño movimiento de algunos astros,

hasta un total de 55. Sin embargo, a pesar de ser el modelo “aceptado

por los dioses”, era incapaz de explicar el zig-zag que describía

un planeta de los más visibles, Marte. A este movimiento se le

conoce como retrogradación, pues Marte describe una estraña

trayectoria en el cielo. Algunos días avanza y otros, retocede parte

del camino avanzado.

|

| Claudio Ptolomeo |

Fué

Claudio Ptolomeo (siglo II d.C) quien consiguió dar explicación a

este extraña trayectoria descrita por Marte y otros astros visibles.

Para ello, introdujo el concepto de los epiciclos. Consideraba que

los planetas describían órbitas circulares en torno a un punto

situado sobre las esperas concéntricas a la Tierra. Por la

superposición del movimiento de la esfera y la órbita del planeta

parecía que éste retocedía en su camino.

El

modelo Ptolemaico subsistió hasta el siglo XVI. En parte porque

cuando Santo Tomás de Aquino cristianizó a los griegos (siglo XII),

la filosofía aristotélica pasó a ser el sustento ideológico del

cristianismo. Por el camino, hubo que modificar el modelo. Se

añadieron más epiciclos (hasta 80), también se desplazó levemente

el centro de las esferas

concéntricas del de la Tierra y más

artificios geométricos para reproducir las trayectorias planetarias

observadas desde la Tierra. El cálculo era, cada vez, más

complicado y la explicación más compleja.

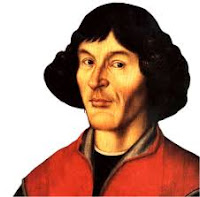

|

| Nicolás Copérnico |

El

trabajo fué declarado herético en 1616 por la Santa inquisición,

aunque aceptado como hipótesis de trabajo durante algún tiempo. Se

enseñaba, por ejemplo, en la universidad de Salamanca (España) y, de hecho,

fué utilizado por el papa Gregorio XII para elaborar el calendario

gregoriano (que seguimos actualmente en occidente) y le sirvió para

corregir desfases en las fechas. De todos modos, nunca se aceptó que

la Tierra fuese un simple planeta más.

|

| Giordano Bruno |

GiordanoBruno, un astrónomo, matemático, filósofo y poeta italiano lo

utilizaba en sus enseñanzas y argumentos contra la iglesia. Llegó

incluso más lejos. Propuso que el Sol era el centro del sistema

planetario, pero que deberían existir más estrellas en el centro de

más sistemas planetarios y que, en algunos de ellos, debían de

vivir animales y plantas, tal y como lo hacían en la Tierra. Fué

acusado de herejía y quemado en la hoguera el 17 de febrero de 1600.

Como en muchos otros casos, un visionario adelantado a su tiempo pagó

con su vida frente al poder y las creencias establecidas.